A principios de 2023 realizamos pruebas breves con Inteligencia Artificial para detectar Inteligencia Artificial. En este post puedes ver el experimento (mayo 2023, con enlace al de febrero 2023).

En aquel momento no nos sorprendió demasiado que los resultados hayan sido adversos para la IA, ya que era bastante reciente el fenómeno y las herramientas nuevas.

De ahí que pensamos que esto le daba mucho aire y larga vida a la tarea docente, entendiendo esta como la de un experto/a en un determindo ámbito o disciplina que valida conexiones, tutoriza procesos y se transforma en referente para el aprendizaje.

Un año más tarde, volvimos a realizar la prueba. Y ahora sí nos sorprendió el resultado ya que alguna vez dijo alguien por ahí que un año en Internet son 10 de la vida real. Entonces, siguiendo esa metáfora estamos una década más tarde! Realizamos exactamente la misma prueba, le dimos el mismo prompt a las mismas 3 herramientas del año pasado, y los resultados fueron sorprendentes. En primer lugar porque los 3 servicios siguen funcionando, y en segundo lugar por la forma en que interpretan el contenido, a pesar de verse mejoras en lo estético o de diseño gráfico.

Entonces, le volvimos a pedir a ChatGPT (usando siempre la versión gratuita) que escriba un tuit como si fuera @pbongiovanni y seguidamente volví a pedirle que escriba un hilo, exactamente con las mismas palabras que el año pasado.

Aquí una captura del "prompt" y sus correspondientes respuestas, realizadas el 10 de febrero de 2024 (Con link al resultado directo en ChatGPT, que el año pasado no lo había hecho.

(Link a resultado ChatGPT: https://chat.openai.com/share/29356cc4-f9ba-4316-8e10-35f840fe825d)

Al igual que el año pasado, a pesar de que le pedí al chatbot de OpenAI que escriba tuits, y a primera vista parecen bien construidos e incluyendo hashtags, tuve que quitar algunos caracteres en los casos que superaban el límite de 280 que es el que sigo teniendo en mi cuenta gratuita de X.

Entonces, a la vez que hacía la prueba, los publiqué con este formato:

Ahora repetimos las pruebas.

Volvimos a copiar desde desde ChatGPT, no desde los tuits, para no "contaminar la muestra" y los fuimos colocando de a uno, en los mismos tres detectores que había usado hace un año:

GPTZero: Desarrollado por Edward Tian, estudiante de la Universidad de Princeton, GPTZero es una herramienta capaz de detectar los textos escritos por un chatbot, basándose en la «perplejidad» o aleatoriedad del texto, una medida de lo bien que un bot puede predecir un texto. O sea, entre más alto sea este indicador, más caos habrá en el escrito y, por lo tanto, más probabilidad de que haya sido creado por una herramienta como ChatGPT.

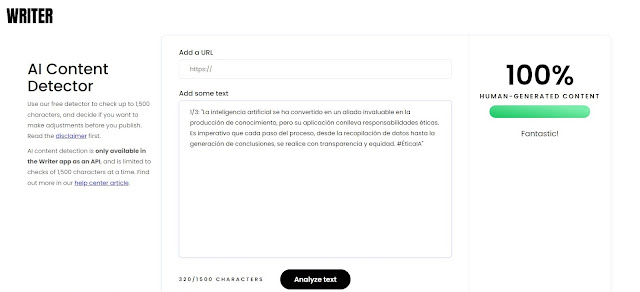

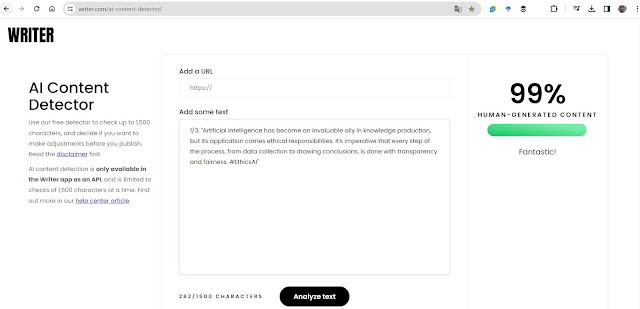

Writer: Writer es un asistente de escritura de IA para equipos, que además incorpora un detector de contenido generado por herramientas de inteligencia artificial. Es muy fácil de utilizar. Solo hay que pegar en la aplicación el texto o la URL donde se encuentra alojado, y en cuestión de segundos el sistema realiza un análisis que arroja un resultado de probabilidad de que el escrito haya sido generado por un humano.

ChatGPT Detector: ChatGPT Detector tiene el poder de detectar si un texto es producido por ChatGPT, valiéndose de funciones lingüísticas o clasificadores basados en PLM. Los resultados de sus análisis son calificados como humano o ChatGPT, aportando un porcentaje de probabilidad.

Ahora aquí capturas hechas con el primer detector: https://gptzero.me/

Primer tuit:

Segundo tuit:

Tercer tuit:

Primer detector: https://gptzero.me/

Segundo detector: https://writer.com/ai-content-detector/

Tercer detector: https://huggingface.co/spaces/Hello-SimpleAI/chatgpt-detector-single

Estos hallazgos resaltan la necesidad de seguir cuestionando la fiabilidad de los actuales detectores de textos, teniendo especial cuidado en el idioma en el cual se constituyen las pruebas, ya que su rendimiento nos mueve a mantener una postura crítica en la evaluación de la autenticidad de los contenidos generados por IA.

Si te sirvió esta entrada ¡compártela!

Hasta la próxima.